①

MAGE: Multi-scale Autoregressive Generation for Offline Reinforcement Learning

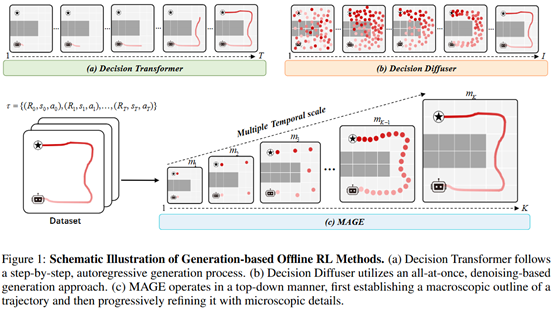

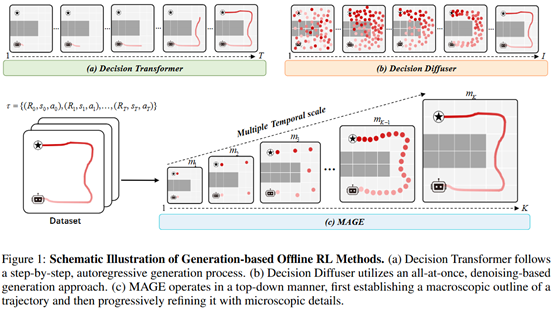

简介:离线强化学习因无需与环境进行在线交互,在机器人控制和具身智能等高成本或高风险场景中具有重要应用价值。然而,在长时序且奖励稀疏的任务中,轨迹数据本身蕴含跨时间尺度的结构特征,而现有方法对轨迹层次性的建模能力有限,可能导致生成行为在全局规划与局部执行之间不一致。针对该问题,本文提出一种多尺度自回归生成式离线强化学习方法 MAGE,通过条件引导的多尺度轨迹自编码器对离线轨迹进行由粗到细的层次化表示学习,在潜在空间中联合建模长期依赖与短期动作。在此基础上,MAGE 采用多尺度 Transformer 对不同时间尺度的轨迹表示进行自回归生成,实现从宏观规划到微观执行的逐级细化,并引入条件引导解码机制以增强生成轨迹的可控性与一致性。该方法适用于机械臂操作和厨房任务等复杂具身环境中的多尺度时序决策问题,并在多个离线强化学习基准任务上取得了显著性能提升。 该论文第一作者是2024级硕士生林晨兴,通讯作者是沈思淇长聘副教授。并由高鑫辉、张海鹏、李欣然(香港科技大学)、王海涛、温程璐教授、刘伟权副教授(集美大学)、王程教授共同合作完成。

②

Getting Your LLMs Ready for Reinforcement Learning with Lightweight SFT

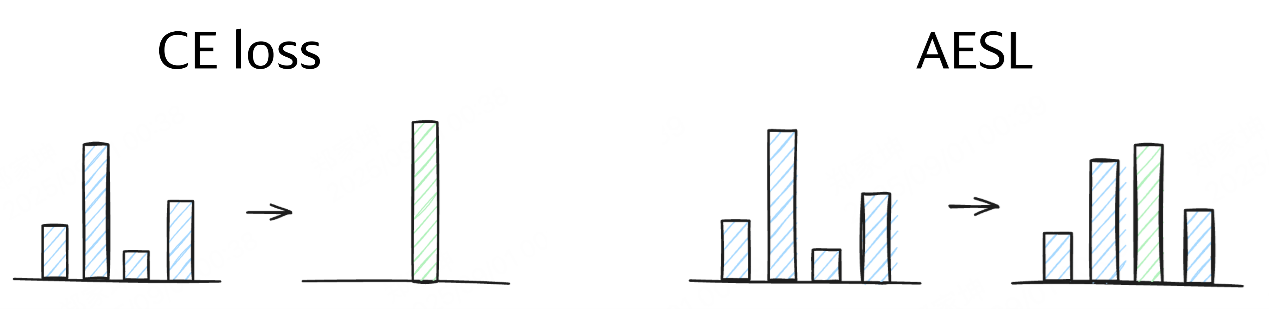

简介:强化学习作为大语言模型的关键后训练范式,其效果却高度依赖基座模型的选择。尽管引入预强化学习的监督微调阶段能提升训练效果,但两个核心问题依然存在:SFT冷启动应训练到什么程度?其训练目标是否真正契合强化学习的准备需求?这个工作在冷启动学习过程分析中发现一个重要局限:评估性能最高的SFT checkpoint,往往并非强化学习的最佳起点。这源于“分布遗忘”现象——模型在传统过拟合发生前,就已过度偏离基座模型的原始分布。这个工作证实,基于熵和自BLEU等多样性指标的早停(early-stop)准则,比传统的性能导向的选择 checkpoint 方法更为可靠。分析显示,多样性达到峰值的SFT checkpoint能持续带来更优的强化学习结果。基于此,本文提出了自适应早停损失(AESL)——一种轻量动态的冷启动方法,它在学习新模式与保持基座模型分布之间实现平衡。AESL在词元与子序列层级同步运作,为冷启动过程提供更精细的控制。数学推理基准实验表明,基于多样性的早停策略显著优于传统SFT方法,而AESL能进一步优化强化学习准备阶段。通过引导大语言模型走向更佳的强化学习初始化起点,AESL在最终性能上持续超越现有SFT及冷启动策略,为大语言模型的高效调优提供了新的技术路径。 该论文第一作者是香港科技大学及阿里集团的李欣然博士,通讯作者是香港科技大学张军教授。并由胡张广达、沈思淇(厦门大学)、陈庆国(阿里集团)、徐昭、骆卫华、张凯夫共同合作完成。