2024年06月17日至21日,计算机视觉与模式识别国际顶级学术会议CVPR 2024在美国华盛顿州西雅图市举行。CVPR(IEEE Conference on Computer Vision and Pattern Recognition)会议由IEEE举办,是CCF推荐A类会议,Core Ranking A*类会议。在2024年谷歌学术国际最新学术期刊和会议影响力排名中,CVPR蝉联第四,仅次于自然科学顶刊Nature、Science,和NEJM。收录的论文代表了计算机视觉和模式识别领域的最新发展方向和最高研究水平,入选标准严苛。据统计,今年共提交了 11532 份论文,2719 篇被接收,录用率为 23.6%。

今年,厦门大学ASC空间感知与计算实验室共有七篇论文工作被CVPR 2024接收。七篇论文的第一作者均线下参加会议(见图1)。

图1:参会博士生颜明、孙啸天、李文、吴海、夏启明、袁直敏和硕士生杨博淳

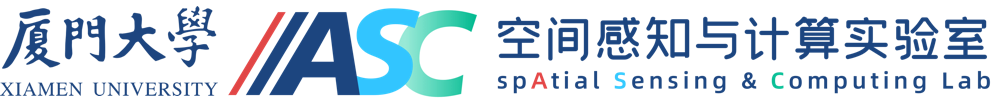

① 《LiSA:LiDAR Localization with Semantic Awareness》

图:硕士生杨博淳现场介绍LiSA工作

论文《LiSA:LiDAR Localization with Semantic Awareness》获得全满分评价,被评选为Highlight论文(入选率2.8%)。

论文简介:

激光雷达定位可估计全球地图中激光雷达点云的姿态。场景坐标回归(SCR)在这项任务中展示了最先进的性能,其中场景被表示为神经网络,网络输出点云中每个点的世界坐标。针对SCR在定位过程中平等对待所有点,忽略了并非所有对象都有利于定位的问题,本文提出了LiSA,首次将语义感知融入SCR以提高定位鲁棒性和准确性。为了避免推理过程中的额外计算或网络参数,将分割模型中的知识蒸馏到原始SCR网络中。LiSA在标准激光雷达定位基准上的性能优越,应用知识蒸馏不仅保持了高效率,而且实现了更高的定位精度。

代码链接:https://github.com/Ybchun/LiSA

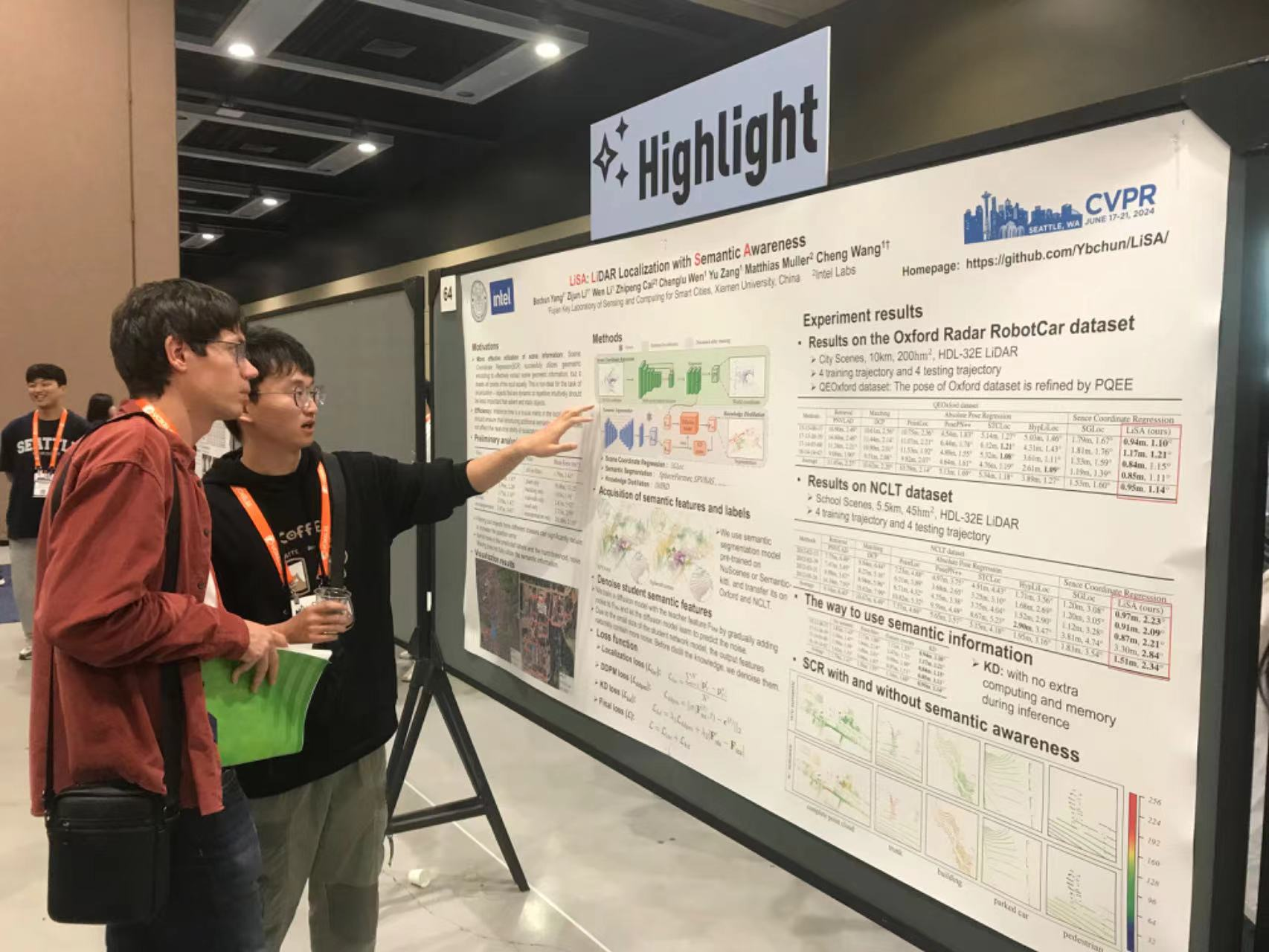

② 《RELI11D: A Comprehensive Multimodal Human Motion Dataset and Method》

图:博士生颜明现场介绍RELI11D工作

论文简介:

针对复杂且快速的全局人体动作捕捉问题,我们基于激光雷达、IMU、RGB相机和事件相机构建了多模态人体运动数据集-RELI11D,包括在 7 个不同的真实体育场景中进行的5项体育运动动作。本文还提出了一种全局人体姿态估计任务上的多模态Baseline-LEIR,设计了适用于人体姿态重建的交叉注意融合策略。实验表明,LEIR 在快速运动和日常运动方面表现出较好性能,且验证多模态数据集特征可有效提升HPE 性能。

项目链接:http://www.lidarhumanmotion.net/reli11d/

代码链接:https://github.com/yanmn/RELI11DandLIER

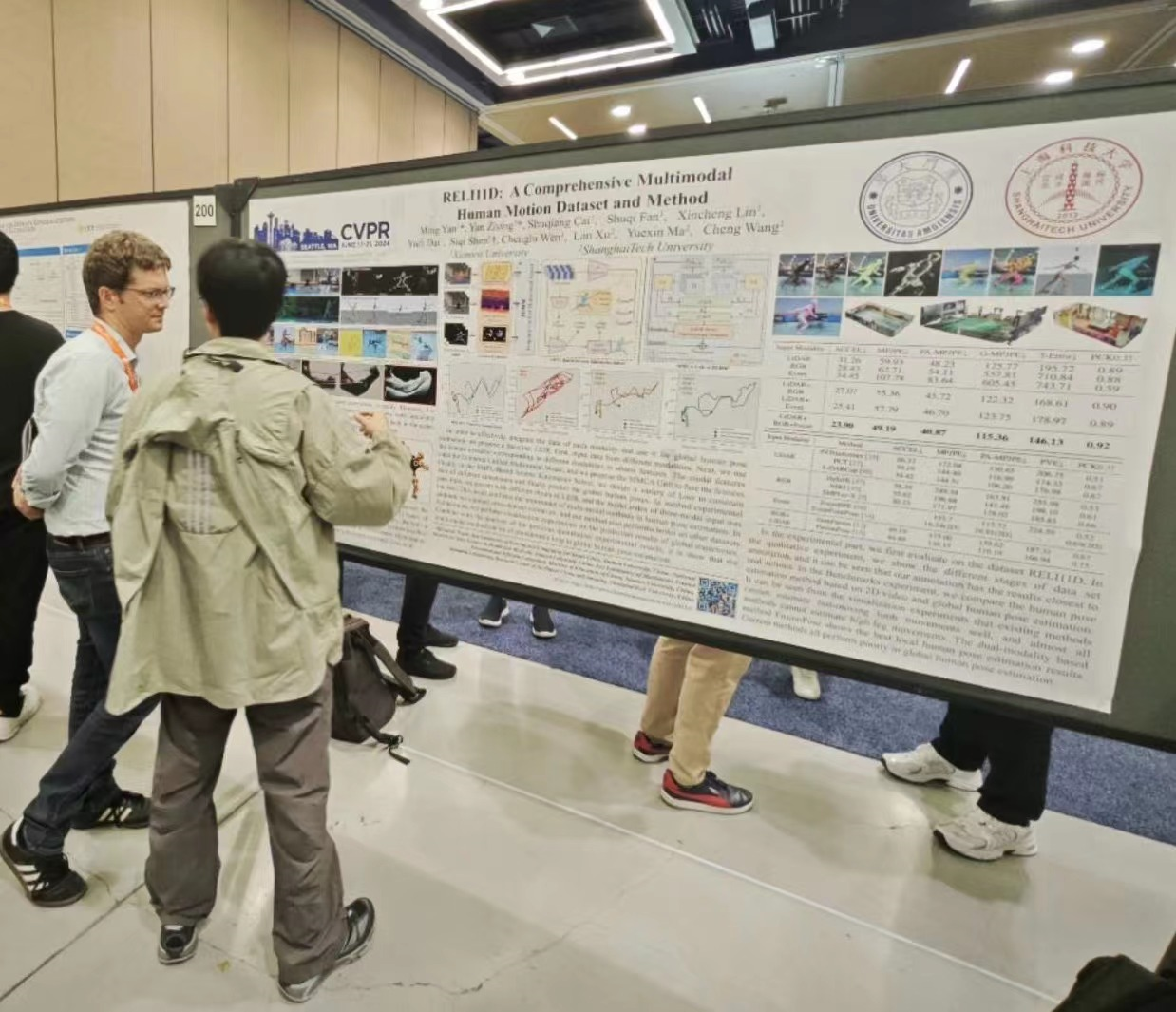

③ 《HINTED:Hard Instance Enhanced Detector with Mixed-Density Feature Fusion for Sparsely-Supervised 3D Object Detection》

图:博士生夏启明现场介绍HINTED工作

论文简介:

本文提出了一种稀疏监督的 3D 目标检测方法-Hard INsTance Enhanced Detector (HINTED)。首先,设计了一个自我提升教师(SBT)模型来生成更多潜在的伪标签,提高了信息传输的有效性。然后,引入了一个混合密度学生(MDS)模型在训练阶段专注困难实例,从而提高检测精度。在 KITTI 数据集上的广泛实验验证了本文方法的卓越性能。与领先的稀疏监督方法相比,HINTED 在困难实例上显着提高了检测性能,尤其是在检测骑自行车等具有挑战性的类别方面明显优于完全监督的方法。HINTED 在具有挑战性的类别上也显着优于最先进的半监督方法。

项目地址:https://github.com/xmuqimingxia/HINTED

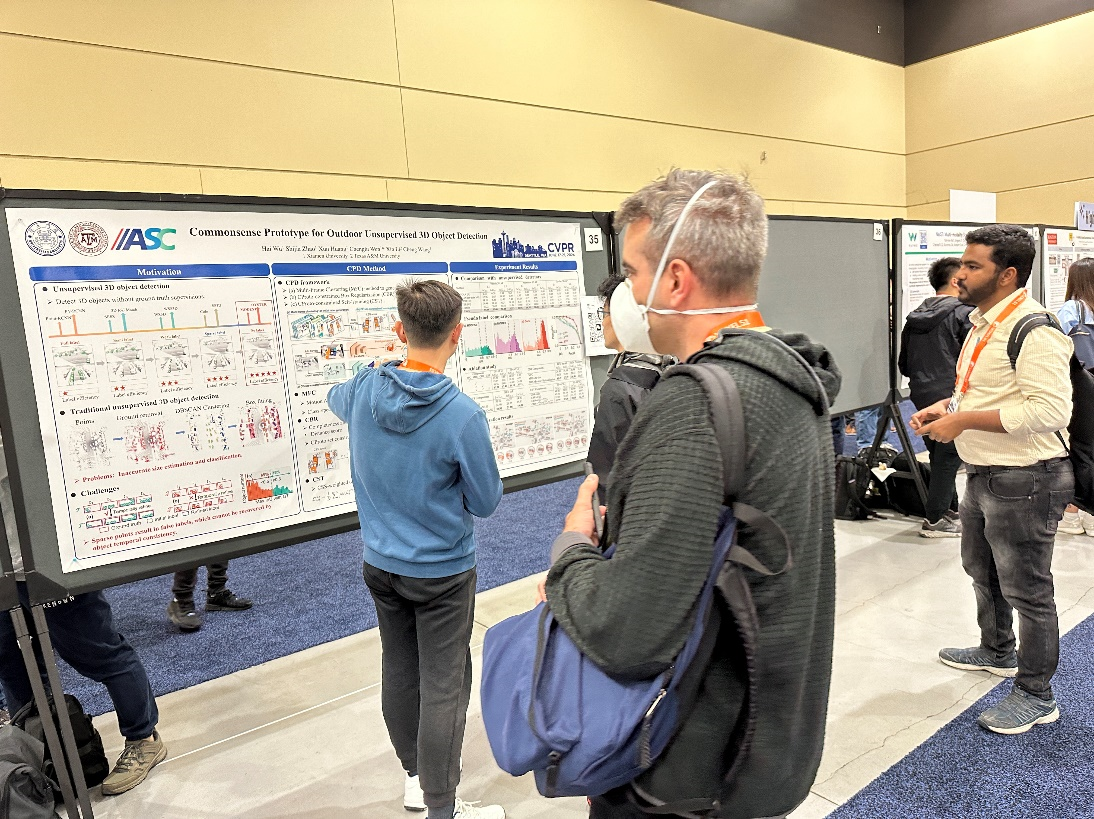

④ 《Commonsense Prototype for Outdoor Unsupervised 3D Object Detection》

图:博士生吴海现场介绍论文工作

论文简介:

本文针对无监督三维目标检测中伪标签质量低、定位误差大的问题,设计了一个新的基于常识原型的目标检测框架(CPD)。首先,本文提出了完整性与形状相似性无监督评分。该评分通过筛选高质量伪标签构建目标常识原型集合。然后,本文提出了基于原型约束的边界框规范化(CBR)。CBR利用原型集合中目标形状先验极大提高了伪标签的质量。最后,本文提出了基于原型约束的自训练(CST)。CST利用原型集合中目标几何先验显著提高了无监督目标检测的精度。该方法在广泛使用的数据集Waymo Open Dataset和KITTI均达到了最先进的无监督三维目标检测精度。

代码地址:https://github.com/hailanyi/CPD

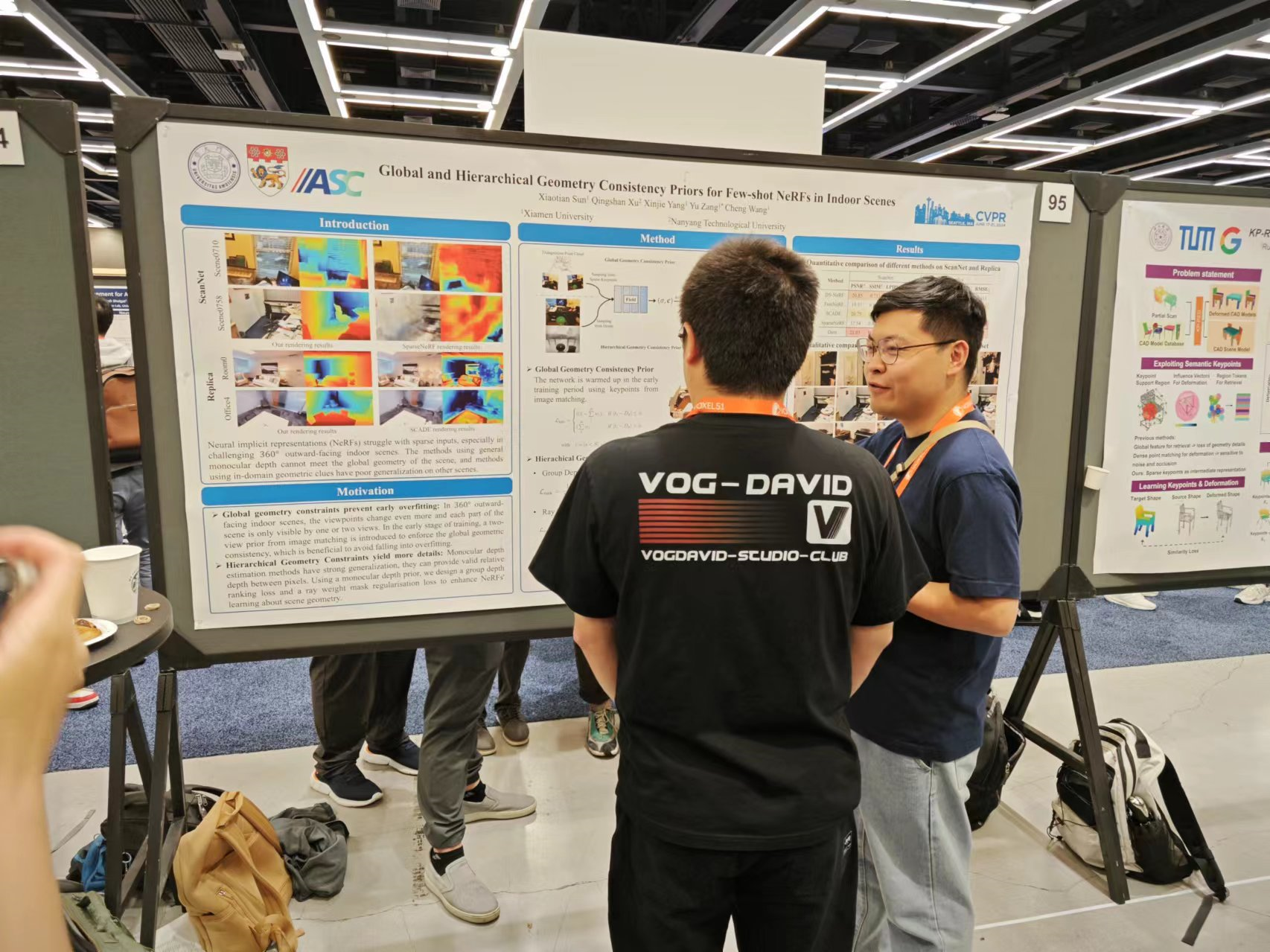

⑤ 《Global and Hierarchical Geometry Consistency Priors for Few-shot NeRFs in Indoor Scenes》

图:博士生孙啸天现场介绍论文工作

论文简介:

本文在稀疏视图神经辐射场的训练中引入了两种几何约束,以解决360°外向的室内场景中视角变化过大造成的的新视图合成质量低的问题。通过在训练早期引入基于图像匹配的全局几何一致性先验来预热神经网络,有效地避免了少样本NeRFs在早期训练陷入过拟合的情况。通过引入几何单目深度估计的层次几何一致性约束,在单视图层面执行分组深度排序约束,在射线权重分布层面执行掩码正则化,进一步强化NeRFs对场景中不同物体位置关系的学习。在ScanNet和Replica数据集上实现了稀疏输入时新视图和深度图渲染的SOTA性能。

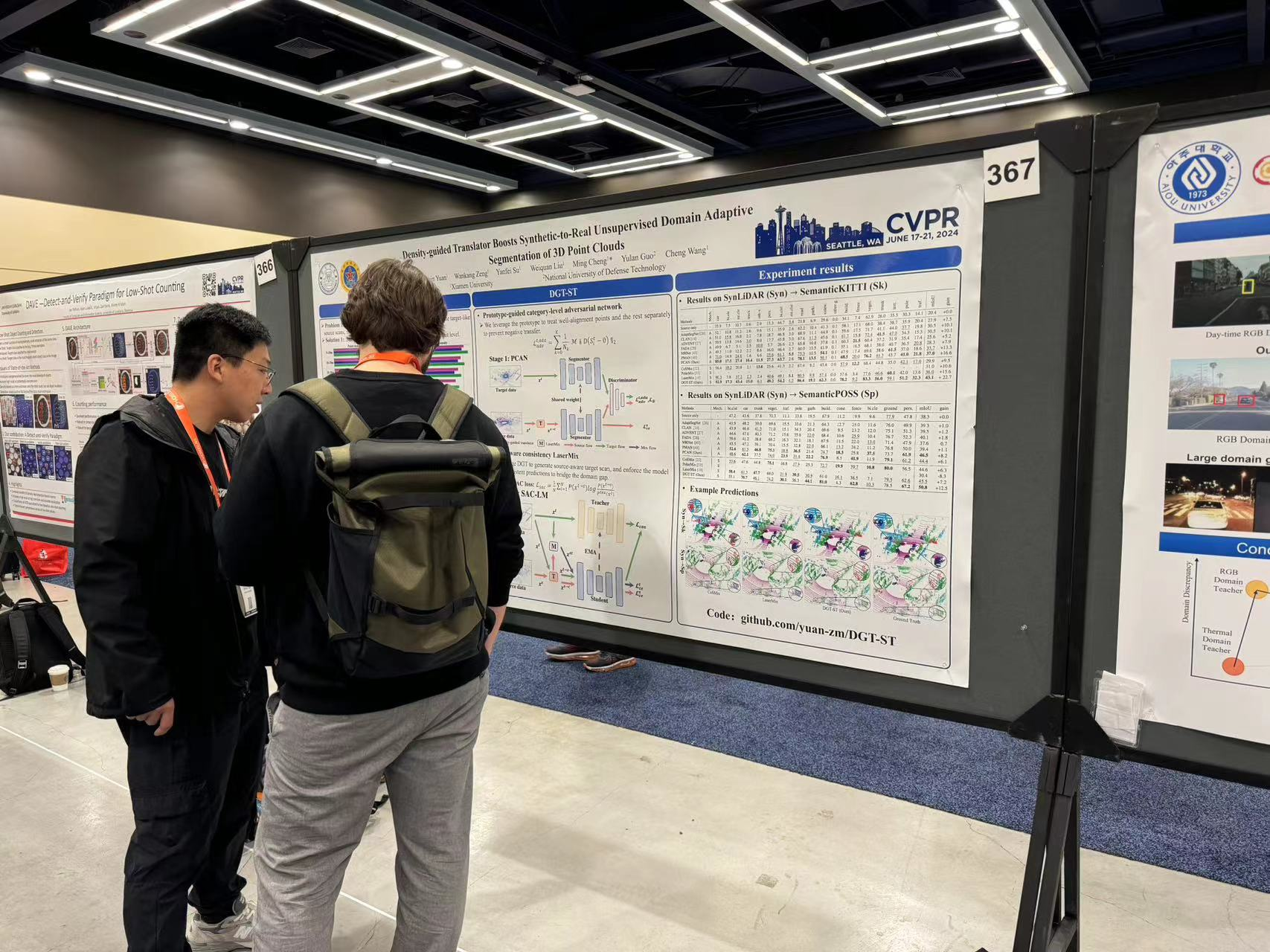

⑥ 《Density-guided Translator Boosts Synthetic-to-Real Unsupervised Domain Adaptive Segmentation of 3D Point Clouds》

图:博士生袁直敏现场介绍论文工作

论文简介:

三维点云无监督域自适应分割可有效减少繁重且昂贵的人工数据标注成本。本文设计了一基于统计的密度指导转换器来解决因不同传感器之间采样模式不匹配所引起的点密度不匹配问题。其通过为每个域生成与其它域相似的点云扫描,以在输入端缩小域差异。并在此基础上,提出了DGT-ST双阶段点云跨域分割框架。在两个公开的合成到真实(SynLiDAR 到 semanticKITTI 和 semanticPOSS)UDA分割数据集上,相较于当前最先进的方法,DGT-ST分别实现了9.4%和4.3%mIoU 的性能提升。

项目地址:https://github.com/yuan-zm/DGT-ST

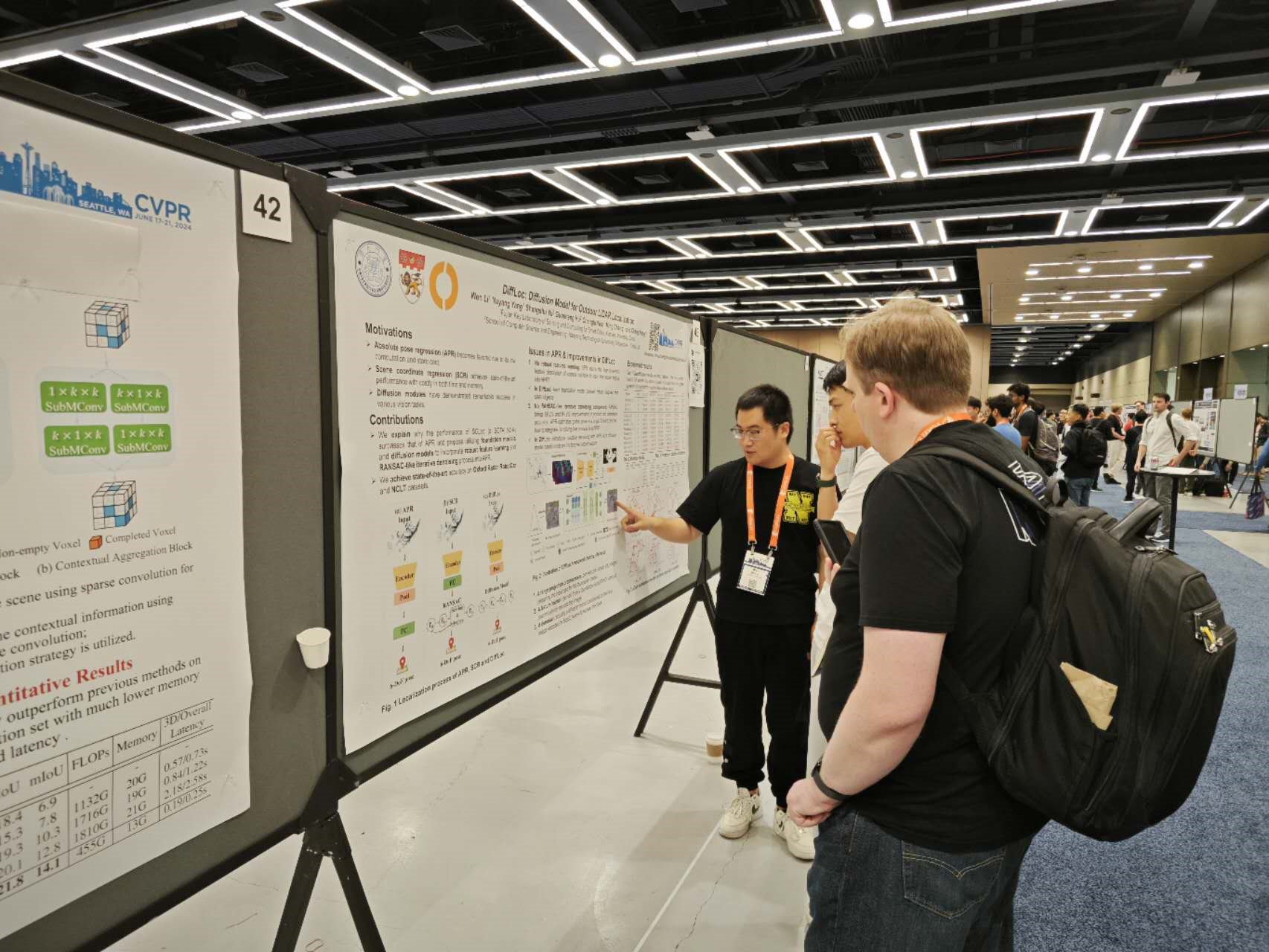

⑦ 《DiffLoc: Diffusion Model for Outdoor LiDAR Localization》

图:博士生李文现场介绍DiffLoc工作

论文简介:

绝对位姿回归(APR)以端到端的方式估计全局位姿,在基于学习的激光雷达定位中取得较好性能。然而,其性能仍远落后于基于3D-3D匹配的方法。本文以3D匹配方法中的场景坐标回归为例进行深入分析,发现在APR中存在着缺少场景鲁棒特征编码和迭代去噪过程的问题。为解决这些问题,本文提出了DiffLoc方法,通过融合基础模型和扩散模型的思想,显著提高了APR的定位精度。此外,得益于扩散框架,DiffLoc实现了位姿不确定性估计,在城市和校园区场景下展现出卓越的性能。

代码地址:https://github.com/liw95/DiffLoc

更多内容,请关注【空间感知与计算实验室】微信公众号