--------------------------------------分割线--------------------------------------

论文标题:FedSAC: Dynamic Submodel Allocation for Collaborative Fairness in Federated Learning

论文地址:http://arxiv.org/pdf/2405.18291

论文代码:https://github.com/wangzihuixmu/FedSAC

论文作者:王子徽(厦门大学),王铮(厦门大学),吕灵娟(Sony AI),彭朝鹏(厦门大学),杨志成(厦门大学),温程璐(厦门大学),俞容山(厦门大学),王程(厦门大学),范晓亮†(通讯作者, 厦门大学)

--------------------------------------分割线--------------------------------------

今天介绍的是厦门大学ASC实验室(asc.xmu.edu.cn)近期被KDD-24会议接收的一篇论文:「FedSAC: Dynamic Submodel Allocation for Collaborative Fairness in Federated Learning」。国际知识发现与数据挖掘大会(简称KDD)是数据挖掘领域的顶级会议,是CCF A类推荐会议。会议每一年举办一届,KDD-24将于2024年8月25-29日在西班牙巴塞罗那举行。

针对现有FL合作公平方法面临的本地模型不一致和忽略对高贡献不公平等研究挑战,本文提出了利用动态子模型分配的合作公平方法(简称FedSAC),它可以在合作公平中有效平衡系统的公平性和模型的准确性。首先,FedSAC提出了“有界合作公平(BCF)”的概念,旨在通过差异化的奖励分配来确保公平性,即根据客户的贡献程度量身定制奖励;其次,该框架通过在聚合模型中删除特定的神经元,为不同客户分配与其贡献相匹配的子模型;然后,FedSAC通过使用一种在聚合过程中平等对待低频神经元的重新对齐机制,以确保模型中各神经元都得到充分训练。最终,FedSAC在3个视觉数据集上的公平性和模型准确性方面取得了SOTA。

--------------------------------------分割线--------------------------------------

研究背景和挑战

研究背景和挑战

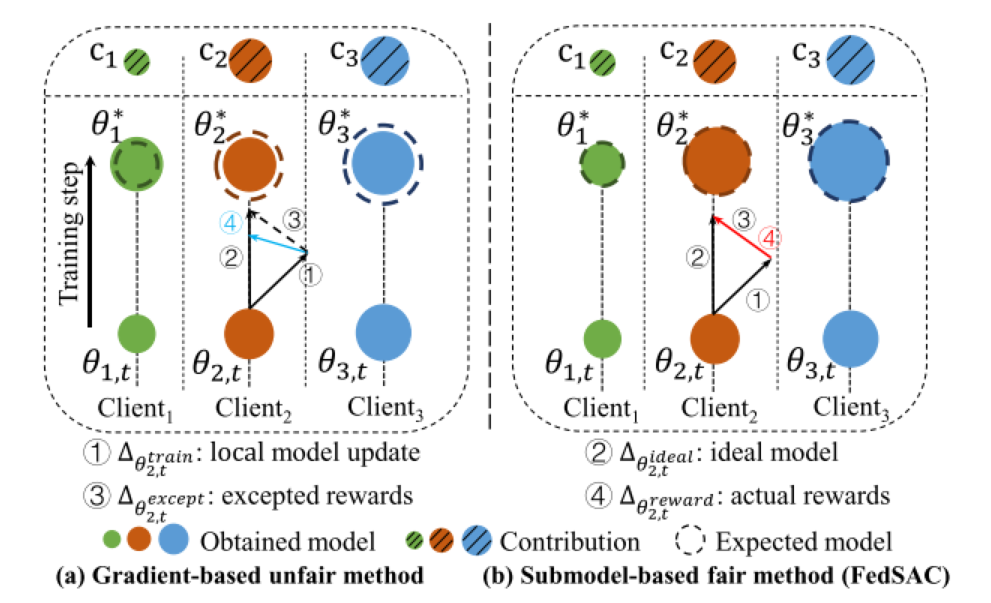

在联邦学习中,合作公平是确保不同贡献的客户在系统中能得到相应的模型性能,从而保证高贡献的客户具有高性能的回报。一些现有方法主要是基于梯度分配的技术来解决合作公平,他们旨在根据每个客户的贡献为其提供相应的模型质量奖励,以确保公平性和效率。他们将更多的梯度数量分配给贡献较高的客户,而贡献较低的客户则得到较少的梯度数量。然后使用皮尔逊相关系数ρ来量化公平性程度,它们可以客观地评估系统的公正性。然而,现有基于梯度的方法在实现合作公平仍然有两大挑战:

挑战1:现有合作公平的定义没有充分差异化客户端之间的奖励分配,导致高贡献客户持续存在不公平现象。这种不公平可能会导致一些客户不愿意积极参与FL。如图1(a)所示,假设和

的贡献分别为

=[1,9,11],他们的奖励分别为

=[99.1,99.2,99.3]。通过传统的合作公平定义,此时的公平性γ=98.97。但此时系统对

和

是不公平的,因为

贡献较低却得到了过多的奖励。在这种情况下,合作公平的度量无法准确反映每个客户端的奖励与其贡献之间的关系,因为它可能会对贡献较低的客户端分配过多的奖励,进而降低了合作公平性。

挑战2:现有方法(基于梯度的方法)依赖于客户端的本地模型更新来实现合作公平,然而,本地模型的不一致性可能会导致整体模型性能的下降。如图1(b)所示,在第t轮后,三个用户的本地模型()存在着显著差异。因此,某些客户端上传的梯度对其他人来说可能不是最佳的,这会导致他们获得的奖励

(客户最终获得的奖励)和期望的奖励

(客户最终期望的奖励)之间出现偏差。

图1. 现有方法导致系统不公平和模型性能较差的两大原因

因此,针对上述挑战,本文提出了一种联邦学习中合作公平的动态子模型分配方法(FedSAC)。首先,我们的方法引入了“有界协作公平”的概念,它旨在差异化分配给各个客户的奖励来确保公平,即根据客户的贡献程度来量身定制奖励。其次,我们提出了具有公平性保证的子模型分配模块,它可以为不同客户分配与其贡献相匹配的子模型。这些子模型是通过聚合模型删除相关神经元而得到的,其中包含的神经元都是较为重要的。第三,我们引入了动态聚合模块,它通过重新对齐机制,在聚合时平等地对待低频神经元。通过这种方式,我们可以更全面地利用所有客户端的信息,从而进一步提高了全局模型的整体性能。最终,FedSAC在3个视觉数据集(CIFAR10、SVHN和Fashion MNIST)上的公平性和模型准确性方面取得了SOTA。本文的研究成果不仅提高了合作公平性,还改善了模型的整体性能,为解决实际的联邦学习挑战提供了重要的参考和指导。

--------------------------------------分割线--------------------------------------

问题形式化

问题形式化

问题定义(有界合作公平)各客户的贡献C和奖励分别根据独立模型(不参与联邦系统训练的模型)和参与联邦后获得的最终模型的性能来计算。用户获得的奖励为

,公平性由

计算,其中

是皮尔森相关系数。γ越大,系统的公平性越好。

--------------------------------------分割线--------------------------------------

FedSAC的总体框架

FedSAC的总体框架

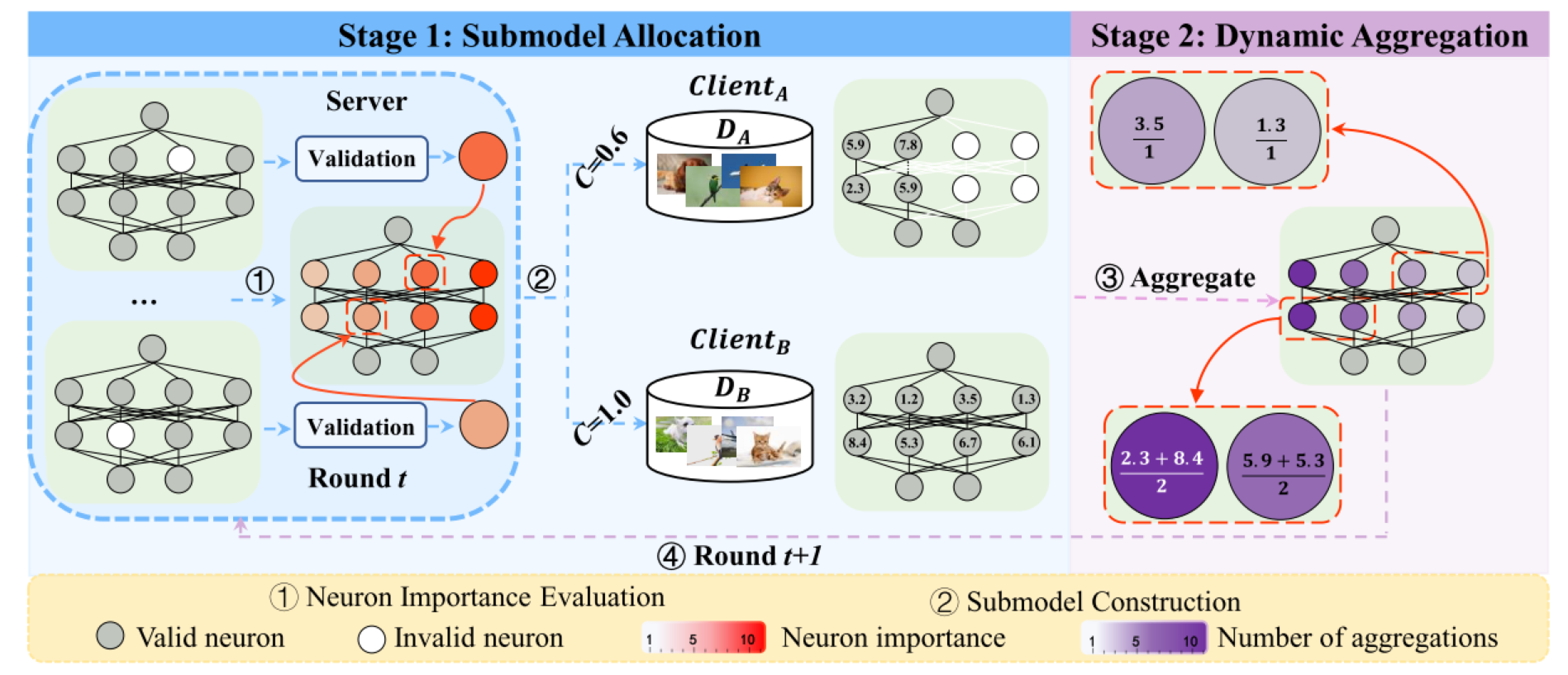

FedSAC算法总体框架如图2所示,共包含两个模块:第一,子模型分配模块可以为不同客户分配与其贡献相匹配的子模型。这些子模型是通过聚合模型删除相关神经元而得到的,其中删除的神经元都是较为重要的。第二,动态聚合模块通过重新对齐机制,可以在聚合时平等地对待低频神经元。通过这种方式,我们可以进一步提高了全局模型的整体性能。

图2. FedSAC总体框架

子模型分配模块的具体流程包括:(1)神经元重要性评估,我们通过移除模型中每个神经元对Validation数据集测试的损失差,来评估其重要性。损失值越大,则表明该神经元越重要。这种方法能够帮助我们更准确地了解每个神经元对模型整体性能的贡献程度,从而为构建个性化的子模型提供了重要的指导。(2)子模型构建,我们结合了一种裁剪机制,即根据客户的贡献从全局模型中构造不同性能的子模型,这种策略允许我们根据客户的贡献来个性化得构造子模型,如图2所示,客户贡献C越大,那么他获得的子模型的大小也越大。

动态聚合模块的具体流程包括:(3)子模型聚合,我们的目标是优化模型内所有神经元的利用率。由于子模型中的神经元分配次数不同,因此在聚合过程中单独处理每个神经元变得至关重要。这意味着需要一种动态的方法来调整聚合过程,以确保低频神经元也尽可能能够为最终全局模型的性能做贡献。为了公平地处理低频神经元,我们将子模型参数聚合的频率作为权重,用于动态聚合模型。

--------------------------------------分割线--------------------------------------

实验与验证

实验与验证

实验设置:本文使用了三个视觉数据集(CIFAR10、SVHN和Fashion MNIST),本地模型为四层MLP网络。更多数据集描述、实验细节设置、基线方法介绍及参数设置,请见原文第5章。

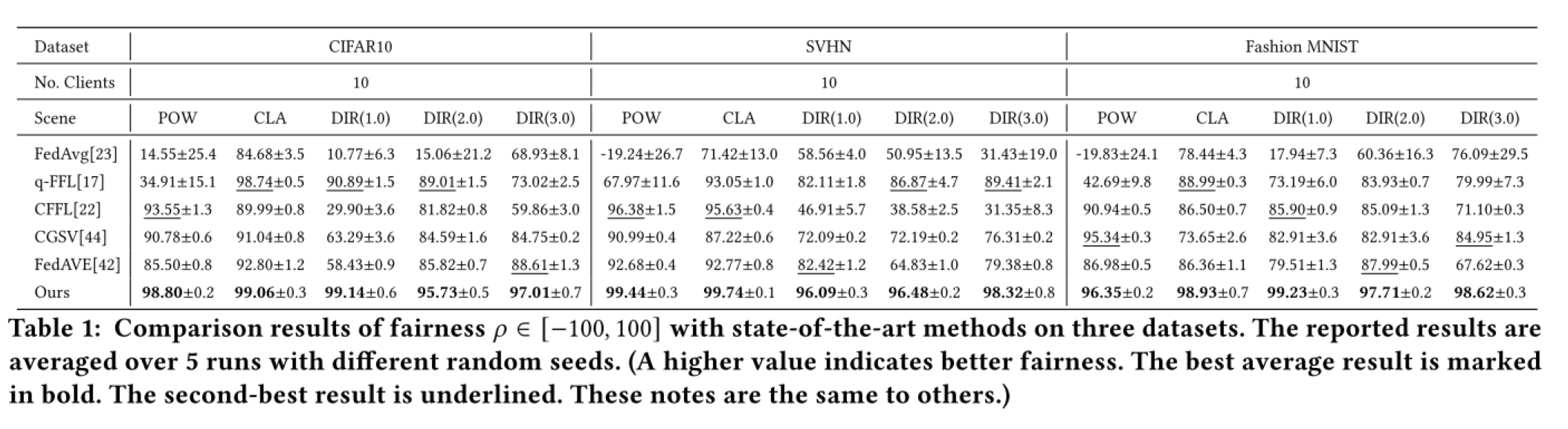

实验结果1. 公平性对比

表 1:公平性比较

表1展示了各种方法在三个视觉数据集(CIFAR10、SVHN和Fashion MNIST)上的公平性比较。结果表明,FedSAC在所有数据集上实现了95.73%以上的公平性指标,并在公平性方面优于最先进的方法。这验证了我们方法的有效性:高贡献客户获得了高性能模型。

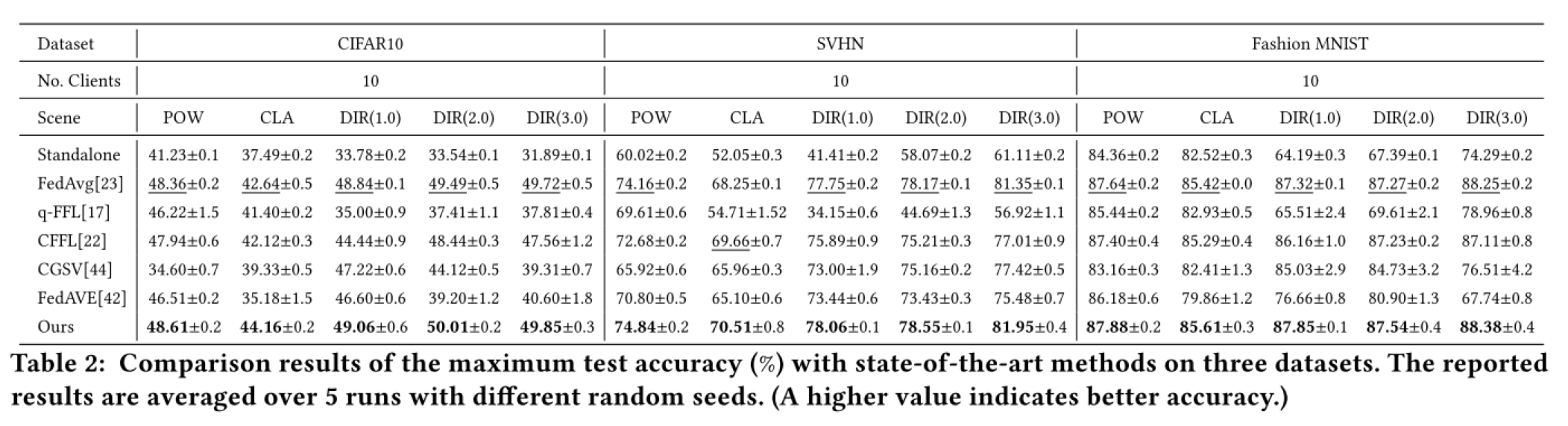

实验结果2. 最大预测性能对比

表2. 最大预测性能比较

表2展示了FedSAC与所有基线方法的最大预测性能比较。首先,将 FedSAC 与 Standalone 的性能(即用户的贡献)进行比较表明,FedSAC的表现显着优于Standalone。其次,在 POW 场景中,FedSAC 在CIFAR10、 Fashion MNIST和SVHN上取得了最高的性能,准确率分别达到 48.61%、87.88%和74.84%。第三,在三个数据集上的 CLA 场景中,FedSAC 获得了最高的准确率,超过 FedAvg 至少0.19%。此外,在极端的非独立同分布场景中(例如 SVHN 的 DIR(1.0)),我们的方法分别比 CFFL、CGSV 和 FedAVE 高2.17%、5.06%和4.62%。最后,对于 DIR(2.0) 和 DIR(3.0) 场景,FedSAC 在准确性方面实现了与基线方法相当的性能。简而言之,FedSAC 在准确性方面优于所有基准。

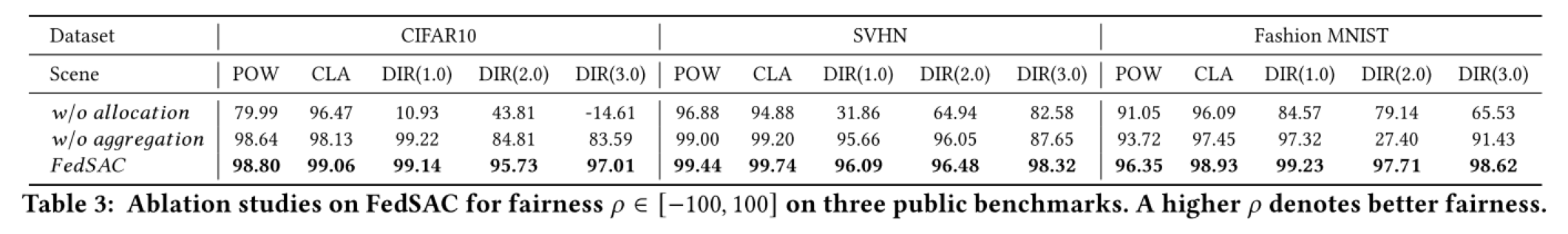

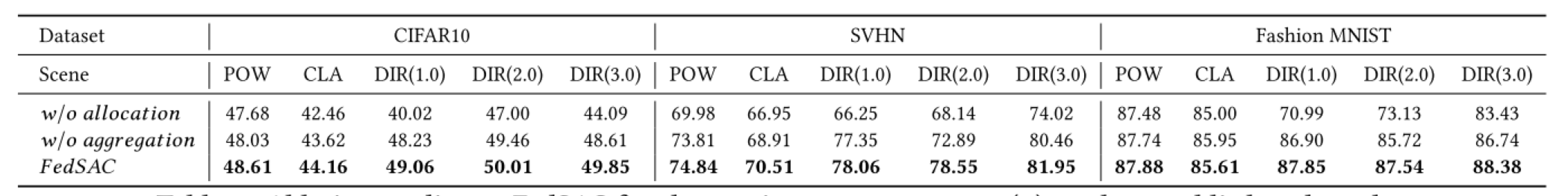

实验结果3. 消融实验

本文还针对FedSAC的两个模块进行了消融实验,分别对子模型分配模块和动态聚合模块的有效性进行了实验验证,表3和表4表明了FedSAC两个模块对于提升系统的公平性和模型性能是最关重要的。

表3 FedSAC在公平性上的消融实验

表4:FedSAC在最大预测性能上的消融实验

--------------------------------------分割线--------------------------------------

总结

总结

本文提出了一种联邦学习中合作公平的动态子模型分配方法FedSAC。该框架根据客户的贡献来分配相应的子模型,这确保有界合作的公平性。同时。它通过保持本地模型的一致性,保障了各客户可以获得较好的模型性能。我们的方法确保高贡献客户可以获得高性能的子模型,同时提高了整体模型的准确性。在三个公开数据集(CIFAR10、SVHN和Fashion MNIST)上的实验表明,FedSAC在公平性方面提升了0.32%-140.14%,在模型精度方面提升了0.04%-43.91%。未来,我们将尝试把FedSAC应用到较大模型(比如ResNet18)中,以提高方法的适用性。

--------------------------------------分割线--------------------------------------

联系作者:范晓亮(fanxiaoliang@xmu.edu.cn)、王子徽(wangziwei@stu.xmu.edu.cn)