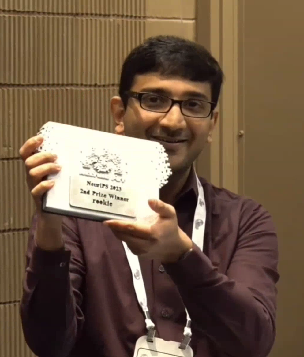

近期,人工智能顶级会议NeurIPS 2023上,由麻省理工学院(MIT)、Google DeepMind和Cooperative AI Foundation(合作AI基金会)主办的Melting Pot多智能体强化学习挑战赛宣布了比赛结果。本次竞赛吸引了全球117个队伍参赛,包括瑞士联邦理工大学、UCLA、新加坡国立大学、清华大学、北京大学、厦门大学、通用汽车公司等队伍参加。厦门大学ASC实验室的Rookie参赛队在全球117支队伍中获得了亚军,仅次于美国通用汽车公司队伍。参赛的同学为23级硕士生秦豪远、邓子微和邓冕,沈思淇老师为指导教师。

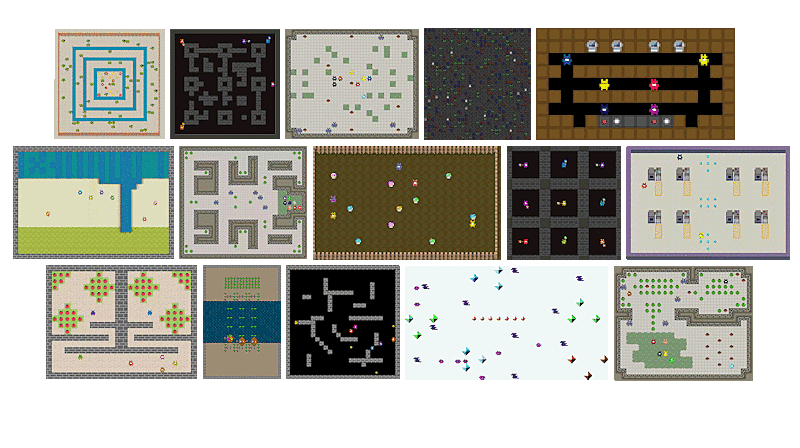

Melting Pot竞赛由麻省理工学院(MIT)、Google DeepMind、和Cooperative AI Foundation(合作AI基金会)联合发起,以推动多智能体强化学习在混合动机协同的进展。这个比赛聚焦于通过团队合作、教学、协商以及惩罚不妥当行为,来达到共同目的。比赛的场景被设计为促进协同,协作,互惠,以及其他的社会友好行为。一个成功的智能体需要能够在个人利益,群体利益,以及不熟悉个体利益之间取得平衡。这个比赛的目的是促进可部署的合作人工智能的进步。研究者可以共同建立协调指标的共识,吸引更广泛的人工智能社区参与,并展示人工智能在团队合作方面的巨大潜力。

比赛详情及技术方案

传统的强化学习环境通常是相对稳定的,智能体在训练和测试中都面对相同的环境。然而,在本次比赛中,测试环境为未见场景并且与智能体交互的背景人群(NPC)数量可变,行为可变。背景人群可能采用不同策略,尤其是在一些社交困境和混合动机的情境中,对智能体的策略提出了更高的要求。

在面对这些复杂的情境时,智能体不仅需要具备出色的个人和群体利益平衡能力,还需要灵活应对各种变化。因此,该比赛不仅仅考验了智能体的智能水平,还要求其在面对不确定性和动态变化时展现出高度的适应性和灵活性。

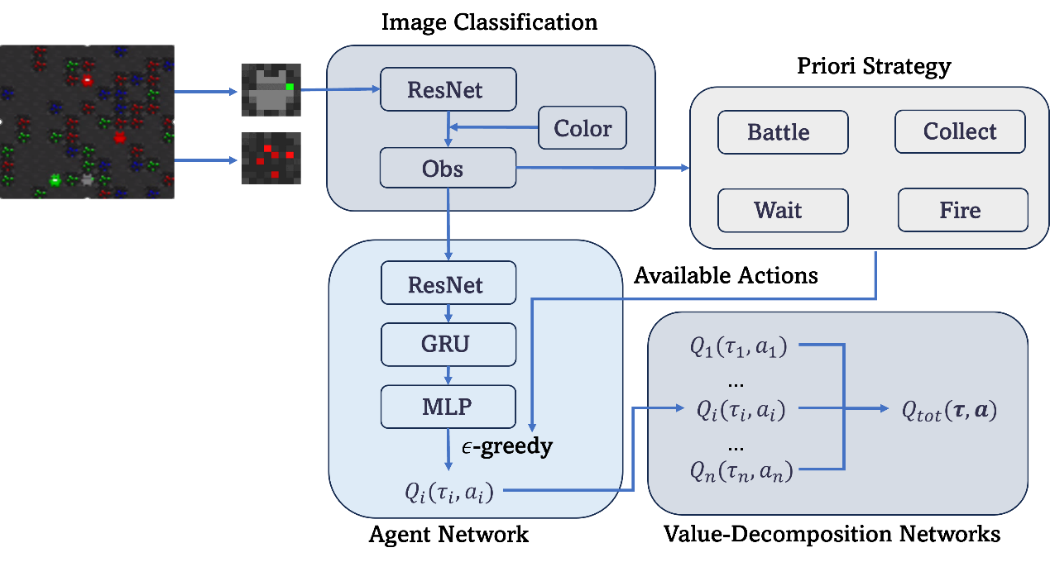

在本次比赛中,大多数队伍采用了被广泛用于大模型训练的PPO算法。厦门大学Rookie团队选择了基于多智能体的强化学习方法,在之前沈思淇老师团队发表的NeurIPS 22[1]以及NeurIPS 23[2]的多智能体强化学习论文基础上进行了改进,在一些协作场景中取得了优秀的表现。

该方法首先将输入的RGB图像分割成基本单位块,每个块都通过采用残差神经网络架构的分类算法进行图像分类,并通过检查图片中最多像素数量的色相来决定颜色。该方法采用残差神经网络提取单个智能体的相对位置观察信息,并结合GRU来存储历史观测信息,从而实现了对智能体间动态关系的建模。与此同时,通过价值分解网络解决了智能体之间的信用分配问题,将全局奖励重新分配给每个智能体的个体奖励,实现了智能体之间奖励的公平分配,从而激励各个智能体更好地合作以达到全局目标。

为了增强智能体在不同场景下的泛化能力,该方法在训练过程中引入了一些由简单程序控制的背景机器人。通过在训练的不同场景下灵活调整背景机器人和智能体的数量,智能体的个体能力和竞争力得到提升,从而更好地适应不同环境。此外,Rookie团队设置了特殊的多智能体团队策略,以确保一些即时动作能够顺利执行。这种策略的使用不仅强化了整体团队协作,还使得每个智能体在个体层面上能够更好地执行任务,为整体性能的提升做出了重要贡献。

引用

[1] Shen et al. ResQ: A Residual Q Function-based Approach for Multi-Agent Reinforcement Learning Value Factorization, NeurIPS 22, Spotlight

[2] Shen et al. RiskQ: Risk-sensitive Multi-Agent Reinforcement Learning Value Factorization, NeurIPS 23