本论文被计算机视觉顶级会议CVPR(IEEE Conference on Computer Vision and Pattern Recognition)2019录用。CVPR2019于2019年6月16日在美国长滩召开,此次会议共收到投稿5165篇,录用1300篇,录用率25.2%。

一、背景介绍

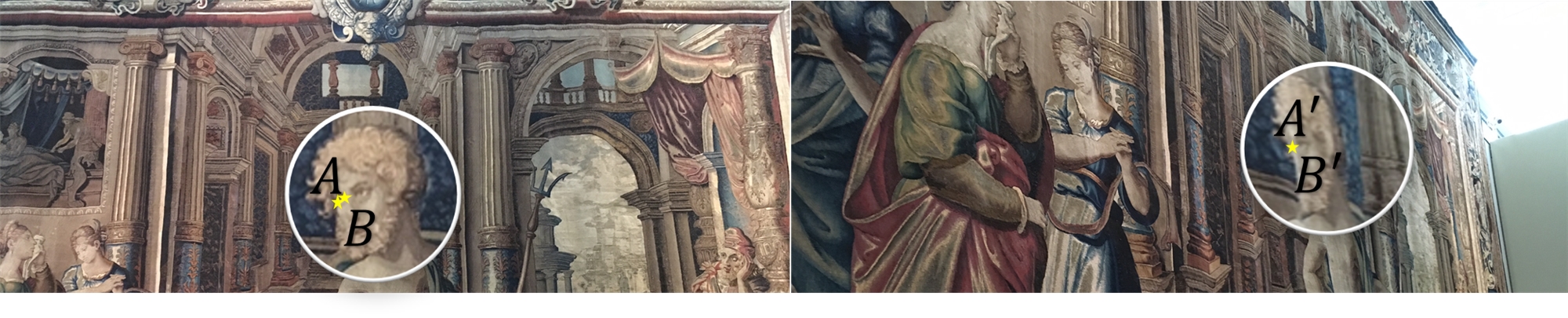

图像匹配在许多计算机视觉任务中扮演着重要的角色,比如SFM,SLAM和图像检索。基于特征的图像匹配方法通常由两部分组成,即检测关键点(包含其属性)和描述关键点。在此之前,不论是传统算法或是深度学习方法,人们一直在努力提升其中一部分的性能,但是,当将某一部分方法整合到流程中时,各自的性能提升不一定能完全的保留。所以,论文创新性地将关键点的检测和描述放入端到端的网络中进行联合训练,并取得优异的性能。

二、方法概括

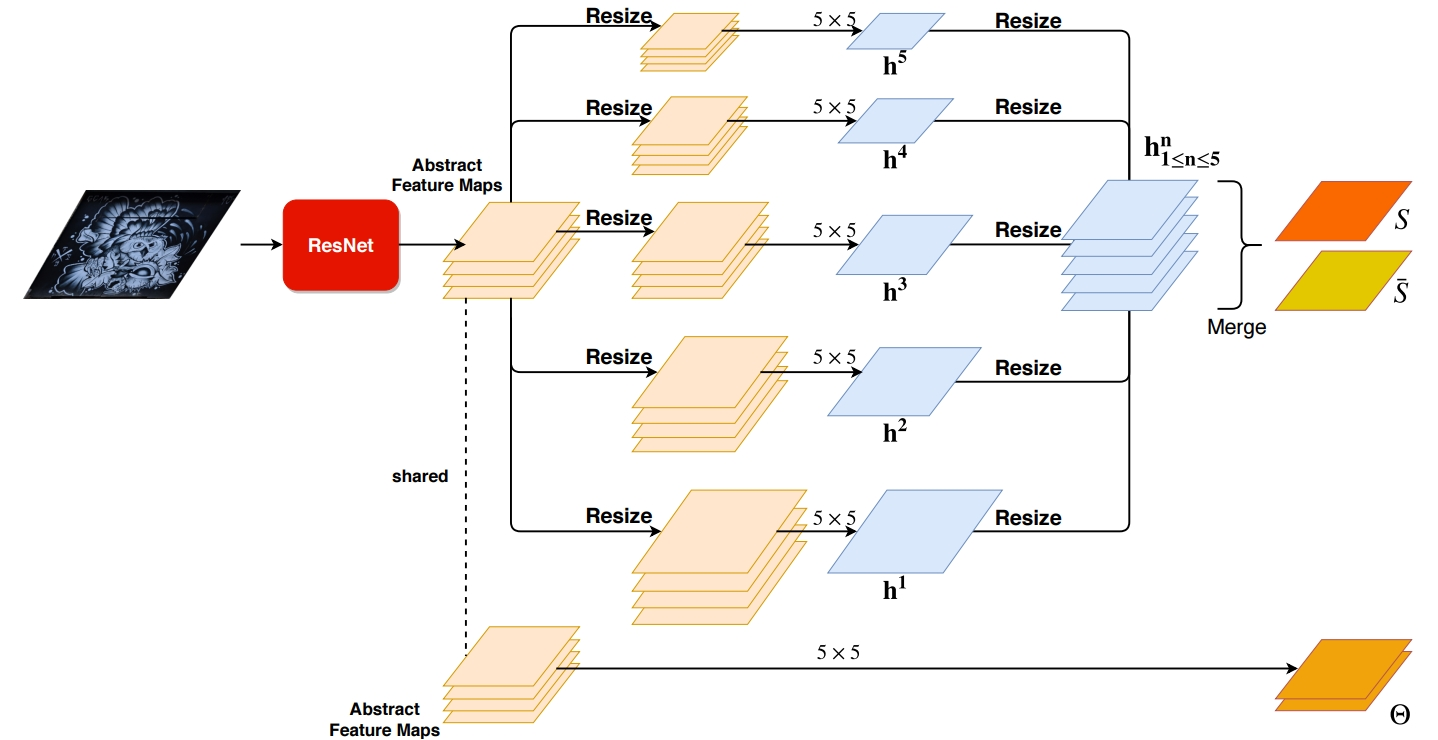

在此之前,Ono等人作为先驱提出了LF-Net,在这个端到端网络中用自监督的方式实现了局部特征的检测及描述。在LF-Net基础上,论文提出了两点改进。

其一,论文提出构建基于感受野的特征层(feature maps),而不是直接用ResNet提出具有大范围感受野的抽象特征层。这样可以在不同感受野(尺度)上对关键点进行检测时减少无关信息的干扰。

其二,论文提出可一个通用的损失函数项,近邻掩码(neighbor mask),以改进在端到端网络中,训练图像块的样本选择。

三、实验结果

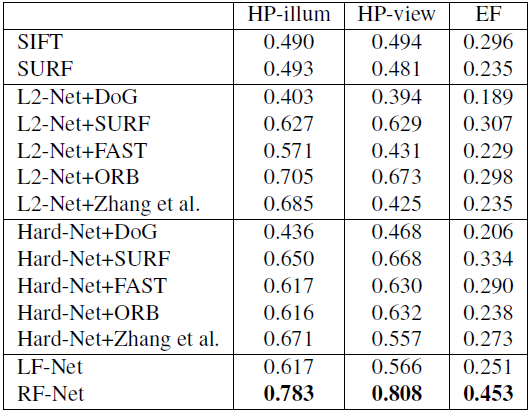

在对比实验中,论文与四种方法进行了对比:

1、传统的detector+传统的descriptor

2、传统的detector+学习的descriptor

3、学习的detector+学习的descriptor

4、端到端的detector+descriptor

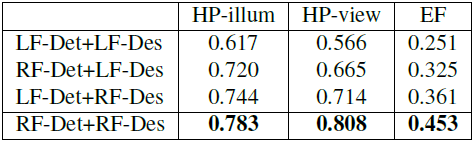

在公开的数据集HPatches中,方法取得了最好的结果。

消融实验也证明了论文方法的有效性。

四、源代码地址

http://github.com/Xylon-Sean/rfnet